多模态代理可以迭代设计实验 以更好地理解人工智能系统的各个组成部分

随着人工智能模型越来越流行,并被整合到医疗保健、金融、教育、交通和娱乐等各个领域,了解它们的工作原理至关重要。解读人工智能模型背后的机制使我们能够审核它们的安全性和偏见,并有可能加深我们对智能背后的科学的理解。

想象一下,如果我们可以通过操纵每个神经元来直接研究人类大脑,以检查它们在感知特定物体方面的作用。虽然这样的实验对人类大脑来说过于侵入,但在另一种类型的神经网络中更可行:人工神经网络。然而,与人类大脑有些相似,包含数百万个神经元的人工模型太大太复杂,无法手工研究,因此大规模解释是一项非常具有挑战性的任务。

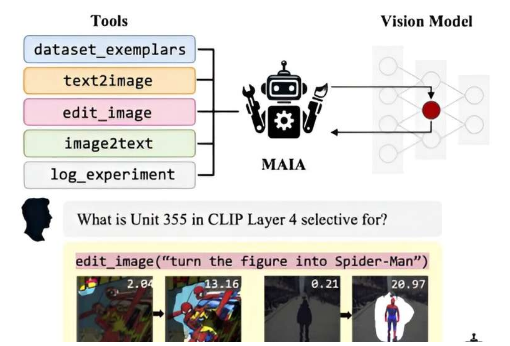

为了解决这个问题,麻省理工学院计算机科学与人工智能实验室 (CSAIL) 的研究人员决定采用自动化方法来解释评估图像不同属性的人工视觉模型。他们开发了“MAIA”(多模态自动可解释性代理),该系统使用配备了在其他 AI 系统上进行实验的工具的视觉语言模型主干,自动执行各种神经网络可解释性任务。

该研究发表在arXiv预印本服务器上。

“我们的目标是创造一个能够自主进行可解释性实验的人工智能研究人员。现有的自动可解释性方法只是在一次性过程中标记或可视化数据。另一方面,MAIA 可以生成假设,设计实验来测试它们,并通过迭代分析完善其理解,”麻省理工学院电气工程和计算机科学 (EECS) 博士后、CSAIL 和这项研究新论文的合著者 Tamar Rott Shaham 说。

“通过将预先训练的视觉语言模型与可解释性工具库相结合,我们的多模式方法可以通过在特定模型上编写和运行有针对性的实验来响应用户查询,不断改进其方法,直到能够提供全面的答案。”

自动代理被证明可以解决三个关键任务:它标记视觉模型中的各个组件并描述激活它们的视觉概念;它通过删除不相关的特征来清理图像分类器,使它们对新情况更具鲁棒性;它寻找人工智能系统中的隐藏偏见,以帮助发现其输出中潜在的公平性问题。

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。